Introduzione Storica

1906 – Gli studi iniziali sul volo delle V-7

Nel lontano 1906, un professore berlinese di elettrotecnica, certo Lewetzov, aveva avanzato l’ipotesi che la forza di gravità che ci tiene avvinti al pianeta sarebbe dovuta ad una specie di pressione esercitata da una invisibile radiazione sconosciuta – “i Raggi L” – dalla natura corpuscolare ondulatoria e proveniente dallo spazio esterno al sistema solare, dimostrando teoricamente che su un piano sperimentale con un complesso di lastre confezionate con una sostanza impermeabile ai “Raggi L” si sarebbe potuto far funzionare un’autovettura, un’aeronave e persino un’astronave.

Il professore Lewetzov era impegnato di questa convinzione, ma egli morì prima ancora di aver dimostrato in maniera tangibile l’esistenza della radiazione tanto vagheggiata.

1929 – Sperimentazione sui “raggi L”

Nel 1° luglio del 1929, il capitano Horst Pinkell, un esperto nelle applicazioni delle alte frequenze riprese a studiare le teorie del professor Lewetzov che lo portarono fino in Russia, stabilendosi definitivamente quando Hitler prese il potere.

Pinkell, lavorò con altri scienziati sovietici nel laboratorio elettrofisico dell’Istituto Zidkowski di Kaluga, ove ruscì a dimostrare l’esistenza della “Radiazione L” o di qualcosa di affine. Poi l’intero staff degli indagatori nel corso del 1940 si trasferì a Maghitogorsk e là venne delineata una speciale “teoria mesonica” giustificante “certi sconcertanti aspetti della questione” e si tracciarono i piani per la costruzione di alcuni veicoli sperimentali azionati dai “Raggi L”.

Diffidando di Pinkell per la sua origine tedesca, allorché le armate naziste invasero la Russia, le autorità sovietiche affidarono la direzione delle ricerche al fisico Andrey Goryev e pretesero un acceleramento dei lavori nella speranza, rivelatasi poi del tutto vana, di poter impiegare in battaglia un rivoluzionario tipo di aereomobile simile, nell’aspetto esteriore ad un “tozzo elicottero” con un rotore a sei pale girante attorno ad una cabina centrale di forma sferoidale.

Un apposito centro venne perciò allestito d’urgenza nella regione uralica di Belaya.

Secondo il controspionaggio tedesco, a Magnitogork si era tentato dapprima di creare una sostanza cristallina capace di assorbire e neutralizzare in varia misura i “Raggi L”, sfruttando dei fenomeni di polarizzazione e di rifrazione press’a poco analoghi a quelli offerti dalla Tormalina, un silicato alluminoso dalle curiose proprietà ottiche ed elettriche.

Riscontrata l’impossibilità di trovare in natura questo tipo di cristallo o di fabbricarlo per via sintetica, gli esperti russi elaborarono in sua vece una lega metallica “preparata in base ad una formula segreta”, avente le richieste proprietà schermanti a comando e risultante efficace per un periodo di circa 12 anni.

1934: I primi progetti

Nel 1934, Hitler che aveva la predilezione per gli outsiders della scienza convocò “l’esperto dell’implosione” presso la Cancelleria del Reich.

Il colloquio tra il Fuhrer e lo scienziato durò circa un’ora e mezzo, lasciando lo stesso Hitler affascinato dalle teorie dello studioso.

Immediatamente Hitler diede disposizioni di inserire le scoperte di Schauberger nelle progettazioni del 3°Reich; ma le violente opposizioni dei rappresentanti delle concezioni meccanistiche, costrinsero Schauberger a ritirarsi dallo staff.

Tra gli esperimenti dei laboratori Messerschmitt di Augusta e nei Sudeti di allora vi erano vari progetti sia nell’aspetto esteriore che nella propulsione dei velivoli totalmente nuovi e rivoluzionari alle concezioni di volo e nella forma dei velivoli d’allora. Tanto che questi progetti di costruzione divennero dopo la guerra motivo di violente speculazioni.

Questi oggetti totalmente inconsueti erano rotondi e a forma di disco, in poche parole assomigliavano nella forma a quegli oggetti che da decenni tengono il mondo con il fiato sospeso e sono chiamati UFO.

Le costruzioni vennero realizzate nelle officine Messerschmitt basandosi sui vecchi progetti e idee di Schauberger la cui partecipazione a queste opere fu sottoposta a Himmler nel 1943 (quasi dieci anni dopo la sua bocciatura iniziale).

Dopo la dichiarazione di guerra agli USA, e l’invasione di truppe alleate in Africa, seguita dalla catastrofe di Stalingrado, Hitler cercava di rialzare il morale delle forze dell’Asse con nuove armi prodigio. Himmler ripose grandi speranze in un oggetto volante ideato da Schauberger .

Nel campo di concentramento di Mathausen, il regno di Himmler, venne messo insieme un team operativo composto da una élite di detenuti scienziati, tecnici e costruttori, che immediatamente il capo delle “SS” mise a disposizione di Schauberger con l’ordine di portare a termine a tappe forzate e con tutti i mezzi; la costruzione di oggetti volanti atti al combattimento. In cambio della collaborazione, Schauberger chiese di lasciar liberi i prigionieri destinati a queste opere e di trattarli come civili, cosa che sorprendentemente il capo delle “SS” concesse subito.

Solo dopo la guerra si venne a sapere che oggetti volanti corrispondenti ai modelli indicati da Schauberger erano stati prodotti anche in altre officine.

Viktor Schauberger – scienziato austriaco (nato nel 1885 – morto nel 1958). Morì in circostanze strane il 20 settembre 1958, dopo varie minacce da parte dei servizi segreti USA. Riuscì a scappare dagli USA rifugiandosi a Linz dove morì.

1935 – Termodinamica e carburanti

Verso il 30 settembre e il 6 ottobre 1935, si svolse a Roma il V°Convegno Volta; dedicato al tema delle “Alte velocità in aviazione”. Il professor H.R.Ricardo, un tecnico di fama internazionale e massimo esponente della ricerca aereomotoristica britannica, presentò un’ampia relazione basata sulla termodinamica e sulla carburazione di motori a stantuffi in alta quota, meravigliando i presenti con le sue rivoluzionarie teorie.

Da quella incredibile e avveniristica teoria, che lasciò increduli buona parte dei tecnici aereodinamici ma coinvolgendo in maniera partecipe d’interesse gran parte delle gerarchie tecniche delle “SS”. Il professore concluse la sua orazione con un’aleatoria teoria che riguardavano quote di volo non ancora sperimentate e per l’epoca ancora impossibili “i 65’000 metri di quota”. Visto che i limiti di quell’epoca era di circa 12’000 metri.

Lo studioso spiegava che l’aria a quella quota sarebbe composta di azoto, idrogeno e ossigeno nelle giuste proporzioni per una miscela perfetta, cosicché il motore risulterebbe addirittura rivoltato nel suo carburante, dando ampio risparmio energetico al velivolo, una migliore maneggevolezza dell’aeromobile ed anche una massima velocità.

Queste teorie crearono tra i presenti lunghi brusii di incredulità e dubbi tra i vari tecnici di aereodinamica, soddisfando invece i sogni dei gerarchi tedeschi, i quali cercarono di approntare già da tempo macchine volanti capaci di volare in parte a quelle fantascientifiche quote.

Infatti, in pochi mesi i gerarchi delle “SS” misero insieme uno staff tecnico contornato da un gruppo di meteorologi impegnati insieme allo studio e costruzione di una rivoluzionaria macchina bellica per il potere del 3°Reich, la quale doveva rendere risultati incredibili.

Per diverso tempo vari cultori nell’ambito delle scienze naturali e celesti, nonché tecnici delle radiocomunicazioni scoprirono che ciò che era stato esposto qualche tempo prima dal professor H.R.Ricardo, non era poi così fantasioso come inizialmente poté apparire.

In seguito si scoprì con sufficiente precisione che la dissociazione dell’ossigeno incomincia a diventare sensibile a partire dai 70 Km d’altezza, e totale verso i 100 Km., mentre a quote superiori si dissociano gradatamente anche l’Azoto e tutti gli altri gas, cui la superstratosfera è realmente uno smisurato serbatoio di energia a disposizione dell’Umanità che non se ne avvale per il semplice motivo che ancora non sa farlo su scala industriale.

Anche la latitudine esercita una grande influenza sui valori della “densità ionica” e i paesi nordici risultarono particolarmente favoriti per il notevole abbassamento della soglia stratosferica e per la vicinanza del polo magnetico terrestre, come provato dalle frequenti apparizioni delle aurore boreali.

1938 – Brevetto della prima turbina monoruota

Nel 1938, l’ingegnere francese René Leduc aveva brevettato una turbina monoruota a combustibile interna con schiera palare del tipo detto a “reazione”. Il flusso dei gas combusti era però assiale interessando tutta la periferia del motore che, a valle, restava avvolto dal suo scarico gassoso. Inoltre, la staticità della camera di combustione, unica e anulare, non avrebbe mai permesso la produzione di quei caratteristici “getti falcati” che sono la causa prima dello sviluppo della “spinta” che sostiene e sospinge i piatti volanti.

I gas sarebbero sgorgati dall’anello periferico, esaurendo la maggior parte della loro energia cinetica nel passaggio attraverso la corona palettata della turbina, che avrebbe dovuto azionare un’elica.

A causa del modesto rapporto di compressione dell’aria e per il basso rendimento globale del sistema, il brevetto Leduc non venne mai realizzato neppure in via sperimentale.

Su questa ipotesi, anche i tedeschi si misero a lavorare riguardo il progetto dei turbomotori a girante unica.

Il turboprogetto Heinkel M.V.O. 001 era stato anche costruito e provato al banco, ma a quanto sembra, era stato abbandonato quasi subito a favore dello sviluppo dei tipi a giranti separate patrocinati dalla Luftwaffe.

La girante, del tipo “a scatola”, portava su di un lato la palettatura radiale centrifuga del compressore e sul lato opposto una palettatura radiale centripeta agente da turbina.

Si notarono, senza dubbio, dei miglioramenti nei confronti del tipo proposto da Leduc, ma non ancora tali da giustificarne l’applicazione pratica sugli aereoplani, assai meglio serviti dal gruppo motoelica, che stava ormai per toccare il vertice delle sue estreme possibilità.

1938 – Progetto di una V7 germanica

Il professor Karl Wagner avrebbe presentato a Hitler il progetto di un aereoplano di forma discoidale, propulso mediante dei “getti” periferici.

Nessuna prova concreta esiste al riguardo, tranne certe esperienze sulle ali (fisse) a pianta circolare, a calotta e a “centro di pressione” fisso, conclusasi appunto nel 1938, condotte principalmente dal dr. M.Hansen e rimaste senza seguito pratico.

1939 – Studi sulla levitazione

Nel 1939, il fisico germanico Braunbeck aveva fatto levitare nell’aria (sulla verticale di una potente elettrocalamita) dei minuscoli dischetti di grafite e di bismunto, ma la guerra aveva troncato quegli esperimenti, forse destinati però a rimanere nel campo della pura speculazione scientifica.

Durante l’Esposizione Internazionale di New York del 1939 presso la Casa della magia era possibile vedere un sottile disco lenticolare di alluminio del diametro di una cinquantina di centimetri che, percorso da una corrente alternata ad alta frequenza sviluppata per induzione, restava sospeso a mezz’aria emettendo una notevole quantità di calore. Quel disco si librava però esattamente sulla verticale di un elettromagnete induttore nascosto sotto il pavimento.

Esso volava sì, ma a “punto fisso”, ossia non poteva spostarsi liberamente nello spazio pena l’annullamento del fenomeno.

1939 – Primi esperimenti sulla levitazione ionosferica

Prima del 2°conflitto mondiale gli osservatori astronomici di Oslo e di Tromsoe avevano accumulato sulla questione moltissimi dati scientifici. In seguito, quando i tedeschi occuparono la Norvegia, alcuni esperti del Servizio Radiocomunicazioni della 5^ Luftflotte segnalarono ai Servizi Tecnici delle “SS” la possibilità seppur ancora embrionale, di sfruttare per il volo stratosferico l’energia dell’aria dissociata riassumendo la forma biatomica ordinaria entro un adatto tipo di motore.

Parallelamente alle indiscrezioni riportate già da tempo, altri studiosi tedeschi stavano già studiando le possibilità di sfruttamento aereomotoristico dello strato ionizzato, lo strato O3 ad elevata concentrazione d’ozono che si estende all’incirca fra i 20 ed i 40 chilometri d’altezza.

I dati norvegesi raccolti vennero in seguito confrontati con le risultanze fornite dalle indagini sulla ionosfera e sui raggi cosmici condotte in Germania presso il Max Planck Institut fur Physik der Stratosphare dal professor Regener di Stoccarda e con quelli ricavati dai radiosondaggi sistematici effettuati dalla Versuchstation Herzogstand di Kochel nell’Alta Baviera. Riscontrando il fondamento scientifico della proposta, si decise di edificare un centro studi nella regione del Telemark occidentale, in una zona boschiva cinta di montagne (presso il distretto del Guasta), e dalla Germania incominciarono ad affluire macchinari, strumenti scientifici e palloni sonda d’alta quota.

In fase pratica, la messa a punto di un “motore ad aria ionizzata” andarono quasi subito deluse, a causa di duplici difetti: la debole concentrazione della percentuale dell’ossidante e quello della ionizzazione dell’aria.

Dopo vari collaudi e modifiche gli studi arrivarono ad una conclusione concreta solamente nel 1943, quando “l’autoreattore rotante” del turboproietto italiano, dotato di bocche multiple e di una modesta sezione frontale del congegno e il relativo peso ridotto della parte motrice fece intravedere negli esperti dell’Ufficio Aereo Tattico della Luftwaffe una possibile soluzione ai problemi inizialmente affrontati.

Lo sviluppo separato ma parallelo dei turboproietti facilitò il corso delle prove.

Gli esemplari costruiti per questo genere di esperimenti venivano fabbricati con del legno bachelizzato per accentuare al massimo la leggerezza del velivolo.

Gli oggetti ionosferici salivano rapidamente ad autoreazione sin verso i 10-15’000 metri in seguito, l’apparato a razzo applicato in via complementare li scagliava (in parte per inerzia) alcune decine di chilometri più in alto, liberando delle sostanze destinate a reagire con l’aria disgregata, che creavano lunghe scie di fumo, quindi molto visibili anche da lontano e facilmente identificabili riguardo l’obiettivo principale da colpire in fase di un attacco nemico.

Alcune incursioni aeree fallirono per la difficoltà nell’individuare dall’alto nel folto dei fiordi i capannoni del centro operativo tedesco.

Infatti, la minaccia permanente dei Commandos inglesi e l’azione capillare dei patrioti norvegesi indussero fin dalla primavera del 1944, le autorità tedesche a trasferire in patria i centri sperimentali operanti.

La lunga peregrinazione si concluse nel grande balipendio prussiano di Hilersleben, poi a Braunchsweig ed infine a Lindau am Bodensee dove ricevette la sua destinazione definitiva il grande raggruppamento di istituti sperimentali segreti di Zell am See nel Salisburgo meridionale.

I dati ricavati dagli esperimenti norvegesi vennero rielaborati per adattarli alla diversa situazione chemiosferica delle regioni comprese fra il 47° e il 48° parallelo (Salisburgo e Carinzia) utilizzando le misure ricavate in precedenza dal professor Cario dell’Istituto di Fisica del Politecnico di Braunschweig; misure adottate dalle analisi spettroscopiche della luminosità notturna spontanea che sulla Germania Meridionale si forma a partire dai 110 Km. D’altezza per la reazione fotochimica sviluppata dalla lenta diffusione del sodio nell’ossigeno atomico delle quote sovrastanti.

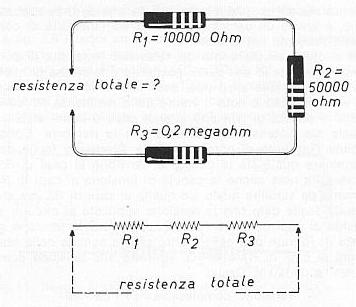

1939 – I compressori radiali pluristadio

L’Istituto F.K.F.S. di Stoccarda aveva iniziato nel 1939 lo studio di certi speciali compressori radiali pluristadio a corone concentriche di palette verticali, che sembravano particolarmente indicati per equipaggiare il nucleo pneumatico di turbomotori monoruota a grande sviluppo diametrale.

Questi strani rotori furono costruiti in pochissimi esemplari, vennero provati al banco dinamometrico e poi scomparvero senza lasciare alcuna traccia di sé e dei probabili sviluppi successivi.

1939 – Primo collaudo di un apparecchio turboreattore

Quattro giorni prima che cominciasse la guerra, il 27 agosto 1939, il collaudatore Von Ohaim provò il primo apparecchio turboreattore del mondo: l’Heinkel HE178. Solo un ristretto numero di personalità ebbe allora notizia di questo avvenimento…

In Germania, lo sviluppo dei primi modelli di caccia a reazione si effettuò con tanta segretezza dimostrando che certi lavori si svolgevano contro gli ordini del Fuhrer.

Lo sviluppo di detti progetti segreti venivano seguiti con il solito e rigoroso metodo germanico consistente nel suddividere i progetti in problemi e i problemi in sotto problemi.

Ad un determinato istituto di ricerca o ad un ricercatore veniva data da studiare (o da risolvere) solo una piccola parte del tutto. Il ricercatore non solo veniva tenuto all’oscuro dello scopo finale del lavoro, ma la frammentarietà della ricerca era tale che egli non poteva neppure sapere che il risultato conseguito doveva servire per l’approntamento di un razzo.

Al tempo delle vicende narrate, l’industria germanica era sotto controllo di due diversi organismi, entrambi statali e riconosciuti: il Ministerium Speer, che coordinava la produzione bellica, sia convenzionale che segreta, e la relativa ricerca, i cui “informatori” agivano pressoché alla luce del sole come dei funzionari di un normale Ispettorato statale; – il Wehrforschungsgemeinschaft, una specie di super comitato per le ricerche belliche, nominalmente alle dipendenze del Reichsmarshall Goring (nella sua qualità, onorifica, di Prasident des Reichsforschungrates) e, ufficialmente, diretto dal suo propugnatore, il prof. Dr. Ing. W. Osenberg, un membro influentissimo del partito, appartenente alla Sezione III SD-SS (Gestapo). Questo organismo, pur essendo stato sanzionato da un decreto hitleriano nel novembre del 1944, aveva cominciato a prendere forma nella sua branca segreta (destinato poi a trasformarsi nello Stato Maggiore Tecnico delle SS) fin dal giugno precedente, avvalendosi della collaborazione di uno stuolo di informatori a diffusione capillare, nell’industria, nelle Università e presso ogni centro sperimentale degno di attenzione.

1941 – Primo collaudo ufficiale di una V7

Il tecnico Hermann Klaas di Mulheim – Ruhr aveva lavorato ai progetti di Shauberger, e basandosi sugli studi di quest’ultimo costruì già nel 1941 il primo modello sperimentale di un disco volante. Invenzione che fu realizzata dai tedeschi e che volò con incredibile successo. L’oggetto a forma discoidale aveva un diametro di m.2,40 con un piccolo motore elettrico speciale , ma molto veloce. Esso si innalzò subito verticalmente, ma andò ad urtare contro il soffitto dell’officina che era alto 8 metri, distruggendosi.

Altre costruzioni vennero studiate sulla base principale di Shauberger da altri scienziati e costruiti in Boemia e più tardi presso Breslau (dove lavorava il gruppo di Miethe). Qui vennero usati un tubo pressostatico più forte (identico a quello usato per le V1). I tre modelli costruiti corrispondevano circa, a parte la disposizione degli ugelli, al prototipo del modello Bellonzo – Schriever – Hamermohl.

Gli ugelli, dovevano essere orientabili per poter ottenere l’ “effetto Coanda”, che rende possibile la salita verticale del disco volante (anche se successivamente Miethe fece una costruzione migliore).

Una volta che il disco aveva raggiunto l’altitudine voluta, passava al volo orizzontale. Ovviamente queste manovre non erano semplici. Oggetti come questi vengono a tutt’oggi costruiti in gran segreto sia in Occidente che in Russia, anzi quest’ultima in due luoghi diversi. Naturalmente vi furono altri progetti e prototipi mai completati.

Miethe, deportato in Siberia, in seguito lavorerà in USA presso la A.V.RoseCompany

1942 – L’aviazione stratosferica

L’aviazione stratosferica su studi presentati nel 1935, fino a quel momento rimasero confinati nel limbo delle più audaci teorie – l’attenzione degli esperti italiani si appuntava su di un tipo di motore a reazione molto promettente, l’Autoreattore, il cui schema, per la verità, era stato proposto molti anni prima dal tecnico francese René Lorin, in base alle ardite, ma corrette anticipazioni di natura gasdinamica.

Date le difficoltà meccaniche insite nel principio, quegli studi non andarono oltre le precise formulazioni fisico-matematiche elaborate dal gen. Gaetano Arturo Crocco. L’interesse sollevato negli ambienti militari fece però nascere l’idea che per ottenere dei risultati concreti con questi ordigni; battezzati “proiettili slittanti” occorreva seguire un diverso indirizzo concettuale chiamando l’Aereotecnica in aiuto alla Balistica.

Lo spunto per l’evoluzione dell’idea sarebbe stato fornito al principio dell’ “ala disco girevole”, proposta dall’Ingegner Guido Tallei in sostituzione delle ali fisse rettangolari.

Il suo curioso aereoplano – che si ispirava al “diri-disco Rota” – risultava infatti sostentato da una grande ala lenticolare, cava e rotante, di forte spessore.

I modelli volanti in scala ridotta nel biennio 1930/1931, avevano confermato la possibilità di ottenere dei buoni coefficenti di penetrazione aereodinamica e una discreta stabilità giroscopica. Tuttavia l’affinamento delle cellule ordinarie e la disponibilità di motori più potenti avevano sconsigliato lo sviluppo della complicata formula, sebbene l’inventore avesse steso nel frattempo i piani dettagliati per un grande velivolo da 50 metri diametrali.

Pare che l’accertamento sperimentale della validità del principio dell’autoreattore venisse segretamente condotto a termine presso un laboratorio distaccato, ma dipendente dall’Università di Torino, con la partecipazione di alcuni esperti della Sezione “Turbine a combustione interna” dell’Istituto Nazionale Motori – adattando allo scopo un “maneggio aereodinamico”, utilizzato in precedenza dal capitano Burzio per la misura della resistenza aereodinamica degli ordinari proiettili cilindrici alle velocità dell’ordine transonico.

La rotazione dei proiettili discoidi, ottenuta per mezzo di “getti” periferici, per risultare efficace ed evitare il ricorso a delle velocità angolari molto elevate, comportava però un forte ampliamento diametrale degli ordigni.

Un proietto discoide, balistico all’origine, era quindi fatalmente destinato a diventare una grande bomba semovente ossia un’aereodina (“turbo proietto”).

L’interesse sollevato negli ambienti militari fece però nascere l’idea che per ottenere dei risultati concreti con i “proiettili slittanti” occorreva seguire un diverso indirizzo concettuale chiamando l’Aereotecnica in aiuto alla Balistica. Ciò – secondo il professor Giuseppe Belluzzo, termotecnico di chiara fama e Ministro dell’Industria nel periodo 1940-1943 – venne appunto in Italia, riadottando per i proietti la forma circolare, alla vigilia della seconda guerra mondiale, ma fu solo nel 1942 cheutilizzando i risultati ottenuti da una segreta unità speciale operante nel 1938 sul fronte nazionalista spagnolo con un tipo sperimentale di proietto piatto e rotondo realizzato in base agli ultimi studi del generale italiano Vittorio Cordero di Montezemolo – venne steso il progetto definitivo di una bomba volante chiamata “turboproietto”. Bomba semovente che era di forma lenticolare e molto economica perché di costruzione relativamente semplice se comparata al complicatissimo razzo tedesco V2.

1942 – I combustibili sintetici (1)

Sin dal 1942 gli studiosi germanici avevano indirizzato le loro ricerche nel settore dei carburanti e delle telearmi. I loro sforzi, dopo lunghi studi ed esperimenti, furono coronati da un pieno successo. Riuscirono infatti a produrre un tipo di carburante di inaudita potenza sottoponendo a particolari procedimenti e reazioni chimiche vari elementi e sostanze fra cui il carbone minerale.

Il carburante estratto da una tonnellata di tali sostanze non superava il quarto di litro e corrispondeva press’a poco a 50 litri di benzina.

La scoperta di questo composto chimico rese possibile in un secondo tempo la costruzione di un aeromobile che accomunava le caratteristiche tecniche dell’aeroplano e dell’elicottero.

Il suo primo collaudo diede però dei risultati assolutamente negativi, in quanto la lega metallica del motore non riuscì a supportare la temperatura sbalorditiva sviluppata dal nuovo carburante.

1942 – La V7 italiana

Secondo il professor Belluzzo, nel corso del 1942 era stato ultimato “nell’intento di fornire nuove armi alla Patria in guerra, il progetto di uno strumento formidabile per la vittoria. Vittoria che si sarebbe realizzata se la moralità e la competenza di alcuni uomini, che oggi vanno per la maggiore, fossero state diverse”.

Il principio meccanico della bomba era davvero geniale e molto semplice. La sezione schematica e le viste fondamentali, di profilo e di pianta, del turboproietto danno infatti una chiara idea del sistema di funzionamento degli “autoreattori rotanti”.

1943 – Nuovo progetto di turboelica

Un progetto più avanzato di turboelica, venne proposto dalla consorziata Heinkel – Hirt, che avrebbero dovuto montare invece un compressore centrifugo di tipo intermedio fra il centrifugo e l’assiale – il “compressore a stadio diagonale” – disegnato per lavorare con delle voluminose mandate d’aria e delle forti pressioni d’esercizio

1944 – Motori sperimentali delle V7

Avendo, nella primavera del 1944, un “motore a schemi verticali” azionato un veicolo in un modo ritenuto già soddisfacente, venne intrapresa anche la costruzione dell’aeroplano. Le direttive di massima urgenza imposte dal capo della polizia segreta, Laurentj Beria, incontravano però l’aperta opposizione degli esperti che giudicava prematuro e quindi pericoloso l’adattamento pratico dei primi ed ancora incerti risultati sperimentali.

Progetto di una V7 (1)

L’ingegnere Alexander Lippisch, presso il Luftfahrtforschung di Vienna progettò un modello di UFO indicato negli incartamenti con la sigla “L-13/A” un modello di forma triangolare con un’apertura alare di soli 6 metri, per una lunghezza di 8 metri ed un peso totale di appena 2’700 Kg.

Questo modello simile ad una punta di freccia, col pilota collocato in posizione prona entro una minuscola cabina prodiera “annegata” completamente nello spessore alare, questo tipo di caccia risultava appunto contrassegnato longitudinalmente da una bassa prima stabilizzazione dorsale. Prima che aveva dimostrato la sua efficienza nelle prove della galleria del vento supersonica di Gottingen fino ad un numero di Mach 3 (pari a circa 3’600 Kn/h).

Sia i piani progettistici che il modello sperimentale caddero in mano alleata quando gli uomini della britannica ““T- Force” entrarono con successo in un accrocco cavernoso austriaco del Salzkammergut, allorché l’Armata Rossa aveva travolto le difese apprestate dai tedeschi nella regione del Lago Balaton scavalcando la “Fortezza alpina” che si rilevò sempre più mattuabile.

1944 – Progetto di una V7 (2)

Un velivolo tedesco ad ali incernierate aveva superato lo stadio di semplice progetto. Anzi, un velivolo del genere era già stato quasi ultimato nel 1944 ad Oberammergau presso gli stabilimenti della Messerschmitt e poi trasferito, in extremis, a Lofer nel Tirolo, dove il Ministerium Speer gestiva un centro sperimentale per delle ricerche speciali di carattere aeronautico e balistico.

Con le ali spiegate, il TAL Gelenkfluegel Flugzeug sembrava uno snello monoplano da caccia, salvo che per l’inversa rastremazione della pianta alare. (Il massimo valore della “corda” veniva infatti a trovarsi all’estremità delle semiali e ciò conferiva al velivolo una eccezionale stabilità trasversale nelle delicate fasi di decollo e atterraggio e nel volo lento in alta quota). Con le ali ripiegate all’indietro sino a combaciare con la fusoliera, per adeguarle alle andature supersoniche, era invece perfettamente simile nella sua forma in pianta a quelle “frecce” di carta con le quali ci si divertiva da ragazzi.

Naturalmente, l’originale velivolo avrebbe dovuto ricevere un potente motore a reazione.

Ancora prima di questo aeroplano, la Messerschmitt aveva impostato ed ultimato il prototipo di un altro velivolo ad ali incernierate, un caccia con ala geometrica variabile, siglato ME- P- 1101.

Nel 1945 stava per passare alle prove in volo quando venne catturato dagli americani.

Per le costruzioni di pre-serie, era prevista l’applicazione di un turbo getto ventrale Heinkel He- S- 011 da 1’300 Kg/ spinta in luogo del mono potente Junkers Ju- Mo- 004- B, montato provvisoriamente sull’esemplare sperimentale, le cui caratteristiche erano le seguenti:

Apertura alare (max) m. 8,24

Lunghezza m. 9,17

Peso Totale Kg. 4’070

Velocità max 981 Km./h a 7’000 m.

Velocità d’atterraggio Km./h 171

Autonomia 1500 Km.

Tangenza pratica 13’800 m.

Armamento da 2 a 4 cannoni Rheinmetall MK 108 prodieri da 30 mm.

1944 – I combustibili sintetici (2)

I professori Sanger e Busemann provarono presso il Luftfahrtforschung “Herman Goring“ di Braunschweig, un combustibile per razzi formato da una sospensione di polverino d’alluminio in olio Diesel che, alla densità limite di 1,2 Kg/dmc., si manteneva discretamente stabile e omogeneo per circa una trentina di giorni, ma poi si convenne che non era pratico e le ricerche vennero troncate.

Altrove, pare nell’Austria superiore, a Linz, o forse ancora più su, a Leuna o nei laboratori segreti sotterranei di Konewka, presso Lodz, le ricerche invece sicuramente continuarono.

Altri centri che si occupavano di combustibili “non convenzionali” operavano a Brux, in territorio sudeto, in Renania e nella Foresta Nera.

A Ludwigshafen, era principalmente il professore Wilke che si occupava di combustibili speciali derivati dalle varie sintesi basate sull’uso del carbone.

A Brounschweig, l’ L.F.A. (Luftfahrtforschung) “Hermann Goring” disponeva, a partire dal 1943, di un apposito Istituto – “la Sezione R” – dedicato esclusivamente alla ricerca sui combustibili per razzi e motori a getto.

L’Istituto manteneva stretti contatti con i laboratori privati delle maggiori case costruttrici di aerei e motori a reazione per uno scambio informativo ed il controllo dei vari esperimenti. Una migliore idea del fervore delle ricerche germaniche nel campo dei nuovi combustibili può forse essere data dal fatto che – mentre esistevano nel 1944 decine di enti militari e civili che si occupavano di queste ricerche, mobilitando un minuscolo esercito di valenti tecnici del ramo – la sola ditta Bayerische Motoren Werke, nel corso della messa a punto del propellente più adatto per alcuni tipi di bombe volanti antiaeree e antinave, sperimentando più di tremila miscele di tipo liquido, differenti per composizione o dosaggio.

Ad un certo punto, questa mole immensa di preziosi lavori incominciò a denunziare il grave inconveniente della carenza di coordinazione (ripetizione delle stesse prove, continuazione di ricerche già fallite altrove ecc.)

Il Comitato per i Combustibili del Ministerium Speer corse egregiamente ai ripari, ma ormai il rapido precipitare della situazione bellica ed i problemi più impellenti (come la produzione della benzina sintetica e l’incavamento delle industrie relative) non permisero praticamente di raccogliere e unificare i frutti, già maturati o quasi, in modo da riversarli sui campi di battaglia.

In un modo altrettanto frammentario, essi fecero poi parte del bottino scientifico dei vari vincitori – occupanti della Germania.

Degli accenni a questo carburante si troverebbero anche negli incartamenti d’archivio sequestrati sul finire del 1945 presso il Kaiser Wilhelm Institut fur Kohlenforschung a Mulheim, nella Ruhr, per cui è ragionevolmente da supporre che il luogo di produzione dei primi campioni sperimentali si trovasse nella Renania, nel Badeno, al massimo, nella Bassa Baviera.

1944 – Collaudo di una V7

Dopo anni di lavoro, di studi e di collaudi, si trovò solo nel 1944 una lega capace di resistere all’enorme calore sviluppato dal “concentrato di carbone”. Cosicché un velivolo dalla forma circolare poté finalmente sollevarsi nell’aria, raggiungendo delle velocità di gran lunga superiori a quelle di tutti gli altri tipi esistenti.

Una caratteristica che distingueva fondamentalmente il nuovo mezzo dagli altri aerei era la sua particolare capacità di innalzarsi in linea retta nel giro di pochi secondi, mettendo in seria difficoltà ogni inseguitore.

Visto il successo delle prove, il Quartier Generale germanico ordinò alora la costruzione di una prima serie di cinque di questi aeromobili e propose di utilizzarli come apparecchi da ricognizione ma, a costruzione ultimata, Hitler ne sconsigliò l’impiego immediato sostenendo che, essendo numericamente troppo scarsi, avrebbero potuto servire meglio in seguito per altri scopi.

Il Fuhrer ordinò personalmente che fossero smontati, caricati a bordo di alcuni sommergibili giganti – gli U Boot XXI – e trasportati presso una base segreta dell’Antartide, o presso la Terra della Regina Maud.

Tutto ciò avvenne poco prima della caduta di Anversa, che diede definitivamente in mano agli Alleati il segreto delle telearmi tedesche V1 e V2.

1944 – Il sistema propulsivo del Lippisch P-13

L’originale sistema propulsivo del caccia P-13 del tipo ad autoreazione, semplicissimo, leggero e assai potente. Risultava infatti formato da un tubo corrente da prora a poppa, con le estremità sagomate in modo tale che durante il volo l’aria vi si ingolfasse attraverso l’apertura anteriore –giungendo fortemente decelerata e quindi autocompressa nella più larga camera centrale che conteneva il combustibile – per poi proseguire, dopo essere stata surriscaldata dalla combustione, verso la parte posteriore del tubo e sgorgare con forza e velocità altissime dall’apertura caudale dell’aereo (che risultava costruito “intorno” al propulsore).

La novità assoluta del sistema era però rappresentata dalla sostituzione della benzina con delle speciali bacchette di carbone collocate a corona intorno alla parete interna del combustore centrale.

Bacchette che venivano portate all’incandescenza all’atto del decollo del velivolo – prodotto da un grosso razzo ausiliario sganciabile ad operazione ultimata – assicurando poi la sua propulsione supersonica.

Per prolungare la durata del volo o aumentarne la velocità, il pilota poteva irrorare il carbone rovente con della paraffina per mezzo di adatti spruzzatori.

Si era calcolato che settecento od ottocento chilogrammi di carbone polverizzato ed impastato in forma di grosse e lunghe bacchette, potessero garantire un’autonomia normale di 45 minuti ad una velocità di circa 1’600 Km./h., aumentabili per breve tempo a 3’000 m. mediante il riferito metodo di ravvicinamento della combustione.

Per appoggiare e in parte anche per avvalersi dei risultati di queste ricerche, nel 1944 gli stabilimenti Skoda di Praga istituirono una sezione speciale – l’Avia Werke – per il progetto e la costruzione di aereoplani da caccia di vario tipo, uno dei quali era previsto per le andature supersoniche e risultava mosso da un propulsore del tutto simile a quello equipaggiante i caccia Lippisch.

Fornitrice del materiale combustibile era la ditta Heinrich Schmitt Werke K.G. di Francoforte sul Meno, che fabbricava vari tipi di bacchette combustibili – con polveri o granuli di carbone macinato e impregnato con delle resine sintetiche chiamate Schaumkohle (schiuma di carbone).

Gli esperimenti preliminari, condotti in sincronismo con quelli del professor Sanger presso i laboratori D.F.S. di Ainring, diedero però dei risultati piuttosto deprimenti: “la “schiuma di carbone” ad un certo punto, per via del forte calore, si sgretolava rapidamente, disattivando il ciclo motopropulsivo dell’aeroplano.

L’avanzata sovietica fece restare il caccia Skoda solo sulla carta, mentre i modelli Lippisch non andarono oltre la fase di prova della galleria del vento, ma nel frattempo gli stabilimenti Schmitt –in seguito intensificata migrazione delle industrie di guerra verso il massiccio alpino – si erano trasferiti nella regione del Berchtesgaden.

1944 – Costruzione di vari modelli di V7

Nell’autunno del 1944 lo Stato Maggiore Tecnico delle “SS” decisero di accelerare i tempi, visto l’evolversi delle avanzate forze alleate concomitanti con gli attacchi russi, rendendosi così conto del breve tempo disponibile; i lavori vennero fatti continuare presso una sezione segreta, operante nei pressi di Lonenghof all’ Istitut fur Radium Forschung, dipendente dall’ Accademia Viennese delle Scienze che li condusse quasi al termine con la partecipazione di alcuni tecnici provenienti dai laboratori dei complessi industriali Siemens – Halske, Allgemeine Radium, Auer Gesellschaft e della sezione “R” dell’ Istituto aereonautico L.F.A. di Volkenrode.

A Lonenghof, venivano studiati anche dei campioni sperimentali di elementi chimici artificiali. Uno di questi radio elementi, venne scoperto da un certo professor Lehman (con la collaborazione dello svizzero Dallenbach) – e chiamato Paulinium in onore del fisico svizzero di origine viennese, Wolfang Pauli (Premio Nobel 1945).

Il professor Lehman – uno dei cosiddetti “Ariani Onorari”, propose di costruire dei velivoli stratosferici di forma piatta e tondeggiante condotti in alta quota da un motore termico (per esempio un razzo) e poi propulsi dal Paulinium pompato e diffuso in modo omogeneo attraverso una superficie porosa.

Quei velivoli avrebbero potuto fare moltissime volte il giro del mondo senza atterrare e, nonostante il modesto carico utile concesso dalla debole spinta complessiva, sarebbero stati veramente preziosi per la ricognizione strategica.

Tra gli svariati modelli proposti, l’Ufficio Aereo Tattico della Luftwaffe prese anche in considerazione un aeromobile preposto su di un progetto dell’ingegner Zollner che lavorava presso il laboratorio chimico fisico di Neumarkt nel Salisburgo – proponendo un elicottero a cabina sferica centrale attorniata – al pari di un pianeta di Saturno in miniatura – avente un anello molto piatto, molto largo e fittamente fessurato in modo da realizzare una specie di vasta elica multipla, alquanto simile al rotore di una turbina o, per meglio dire, a quello di una parte pneumatica dei “Turbo fans” anglosassoni di recente costruzione.

La poderosa discarica elettrostatica – da innescare solo ad una certa distanza di sicurezza dal suolo – attraverso il bordo d’uscita (conduttore) dei profili palari simultaneamente assicurava la rotazione dell’anello palettato (componente tangenziale) e provvedeva alla traslazione dell’aeromobile sia tramite l’aria accelerata da quella specie di elica, sia grazie alla componente assiale della spinta elettrostatica.

Dal ventre dello sferoide centrale un effusore doveva proiettare in continuità un velocissimo flusso di vapori – provenienti dal circuito interno di raffreddamento del generatore – che funzionavano nel contempo da secondo elettrodo per la scarica della polarità di segno opposto.

1944 – Sabotaggi alleati alle V7

Ai primi del mese di settembre 1944 il Fuhrer in persona aveva insignito del “distintivo d’onore Fritz Todt” nove inventori i cui nomi nell’interesse della produzione bellica germanica “erano stati tenuti accuratamente segreti.

L’intercettazione telefonica di colloqui di alcuni gerarchi nazisti della Propaganda offrì delle preziose indicazioni sul genere delle ricerche e sulla ubicazione dei laboratori segreti diretti dagli esperti decorati.

Gli alleati, pazientemente e pericolosamente schedarono e controllarono le informazioni raccolte, ogni elemento venne vagliato alla luce delle precedenti azioni di sabotaggio. Fu a questo punto che venne presa in seria considerazione la complessa e rischiosa contro – operazione denominata “Tarzan” destinata a sconvolgere tutti i piani nazisti per l’allestimento delle “armi segrete dell’ultimo minuto”.

Simultaneamente gruppi di false “SS”, in seguito identificate quali agenti inglesi, penetrarono di notte nei laboratori decentrati e sottoterra ubicati nel Tirolo, Salisburgo, Carinzia e Foresta Nera, dinamitando le apparecchiature e i macchinari, asportando i documenti più importanti e bruciandone gli archivi.

Otto scienziati: i professori Haver, Hummel, Wisch, Starke, Von Zschocke, Bucker, Ergang e Von Muckle caddero sotto l’attacco degli alleati.

Le autorità tecniche naziste accusarono in silenzio il grave colpo che le privava praticamente di ogni possibilità di riscossa e minimizzarono il fatto in un rapporto inviato ad Himmler richiamando a disperata raccolta tutte le forze e le disponibilità superstiti.

Altri campi sperimentali vennero scoperti dall’avanzata alleata solo dopo lo sfondamento del fronte germanico ad Hillersleben efficentemente bombardati dall’VIII° Squadra aerea americana e della RAF, stroncando definitivamente i lavori Germanici.

L’operazione “Tarzan” unita all’attacco ad Hillersleben anticipò le mosse tattiche dei tedeschi che dopo l’occupazione norvegese, prescelta dai tedeschi per l’erezione di aerodromi particolarmente attrezzati per il bombardamento delle isole britanniche e parte del continente americano. Infatti i campi di Vaernes e di Stavanger potevano già ospitare non meno di quattrocento velivoli speciali, e la prima incursione era stata fissata nel quadro dell’”Operazione Osterei“, per il 27 aprile 1945.

Note (Composizione dei laboratori sotterranei)

Un enorme complesso sotterraneo degli stabilimenti Mittel – Werke e denominato dai tedeschi con il codice: M-Werke, operante tra le montagne dell’Harz nei pressi di Nordhausen, era formato da due lunghi tunnel paralleli, lunghi ciascuno un chilometro e mezzo e collegati fra loro da 62 gallerie trasversali minori per un totale di circa 20 Km. Di installazioni sotterranee.

Possedevano dei minuscoli fortini sferici prefabbricati in cemento – chiamati “Kugelstand” – incapsulati nottetempo nel terreno in modo da risultare praticamente invisibili anche a distanza assai ravvicinata. Le “Kugelstand” erano degli sferoidi cavi di cemento armato del peso di 1’700 Kg. Co un diametro interno di metri 2,40, risultanti dalla unione di sei parti prefabbricate, costruite sul progetto della ditta bavarese Dyckerhof e Widmann che, nel novembre 1944, li propose alla Wehrmacht come fortini facilmente trasportabili, interrabili, inaffondabili nei terreni paludosi e invisibili alla ricognizione aerea. Nonostante il modesto spessore del guscio della costruzione (cm.4) i primi esemplari sperimentali sostennero senza danni il sovraccarico costituito dal passaggio di un carro armato pesante.

La lunghezza minima della pista di decollo era delle seguenti dimensioni:

Lunghezza della volta m.325

Larghezza m.135

Altezza centrale m.45

Spessore della volta in cemento armato m.5,30 con ulteriore riporto di terriccio, da farsi a costruzione ultimata, allo scopo di aumentare sino a 7 m. lo spessore protettivo, creando così delle oblunghe collinette artificiali fittamente ricoperte di vegetazione erbacea e boschiva, attorniate da propaggini irregolari simulanti delle naturali elevazioni del terreno per ingannare la ricognizione aerea.

1944 – Le apparecchiature per interferenze magnetiche

Nell’autunno del 1944, a Oberammergau, nella Baviera alpina, il centro sperimentale della Luftwaffe, l’O.B.F., aveva ultimato una serie di ricerche riguardo a delle apparecchiature elettriche capaci di interferire sul funzionamento dei motori fino ad un massimo di 30 m. di distanza, mediante la produzione di intensi campi elettromagnetici. Mettendo così in avaria i motori di un aereoplano provocandone l’immediata caduta.

Approvato il progetto, lo Stato Maggiore Tecnico delle “SS”, aveva adattato l’idea del “radio-disturbo” da poter applicare su un nuovo velivolo che era in fase di collaudo presso una base segreta dello Schwarzwald.

Questa macchina nata per il disturbo aereo nei confronti dei continui attacchi nemici, aveva una forma rotonda e corazzata, molto simile al guscio di una tartaruga, era mossa da uno speciale motore a reazione, anch’esso piatto e circolare, il quale generava un vasto alone di fiamme luminose.

Il suo nome di battesimo fu “Fuerball” (palla di fuoco). Non portava né armi e nemmeno piloti, era radiocomandata solamente all’atto del decollo, ed una volta in quota, inseguiva l’obiettivo, senza entrarne in collisione, ma solamente accostandolo ed emettendo il suo raggio invisibile di disturbo, quanto bastava per far impazzire le bussole di bordo e il radar, nonché ponendo in crisi il funzionamento del motore dell’aereo nemico.

Il fiammeggiante alone provocato era ottenuto con una combustione molto “ricca degli additivi chimici diselettrizzanti, jonizzando intensamente l’atmosfera nelle adiacenze dell’aereoplano, generalmente in corrispondenza delle estremità alari o degli impennaggi, assoggettando il radar di bordo H.2.S. L’azione di potenti campi elettrostatici ed elettromagnetici pulsanti, generati questi ultimi da grandi radio-valvole Klistron catafratte e recanti una speciale protezione sia antiurto sia anticalore.

Siccome un arco metallico percorso da una corrente oscillante di opportuna frequenza – uguale cioè a quella impiegata dalla stazione radar – può cancellare i “blips”, ossia le onde di ritorno del bersaglio, i “Fuerball“, pur così visibili nella notte, sfuggivano praticamente al rilevamento dei più potenti radiolocalizzatori americani del tempo.

Più di una volta i piloti americani ed alleati si trovarono faccia a faccia con questi ordigni, e in tutti i casi, senza potersi dare una spiegazione, si tennero sempre a debita distanza, evitando qualsiasi azione sia d’attacco che difensiva nei confronti di questi aeromobili di disturbo.

Il progetto del “Fuerball” venne realizzato dapprima presso gli stabilimenti aeronautici di Wiener Neustadt, col concorso del Flugfunk Forschunganstalt di Oberpfaffenhoffen, importante istituto governativo operante a 30 miglia a sud di Monaco di Baviera, e impiegante circa 800 tecnici per le ricerche nel campo delle alte frequenze, il radiocomando missilistico, le apparecchiature radariche, le radiazioni infrarosse e l’elettronica in genere. Diretto dal Prof. Dieckman, seguito poi dal dottor Ahrens.

A testimonianza di chi vide allora i primi brevi voli di collaudo dell’ordigno, ancora privo di dispositivi elettrici, assicura che “…di giorno esso aveva l’aspetto di un disco luminoso rotante su sé stesso e di notte appariva come un globo in combustione”.

Lo stesso Hermann Goring ispezionò varie volte quei lavori perché sperava, come infatti avvenne che il principio meccanico potesse produrre in seguito anche un’arma offensiva capace di ribaltare l’esito della guerra di quel periodo.

Quando i russi incominciarono a premere in direzione dell’Austria, la costruzione dei primi “Fuerball” armati, venne continuata da alcune officine incavernate nello Schwarzwald, ove lavoravano alle dipendenze degli stabilimenti Zeppelin- Werke.

Questi stabilimenti prima del suo decentramento sotterraneo nello Schwarzwald avevano già lavorato nel campo delle apparecchiature radariche segrete, costruendo i riflettori parabolici per i radiolocalizzatori terrestri, attirando sulle officine di Friedrichshafen presso la frontiera svizzera l’”attenzione” dell’Intelligence Service e della RAF un pesante bombardamento da parte di sessanta quadrimotori Lancaster il 20 giugno 1943.

Analogo massiccio bombardamento avvenne nell’ottobre del 1944, quando una pesante incursione britannica ridusse ad un cumulo di macerie la grande stazione di radio disturbo anti-aereo ubicata sul Grosser Feldberg nel massiccio del Taunus. Il centro, che ospitava le migliori apparecchiature tedesche, per la sua posizione geografica proteggeva i distretti industriali della Ruhr e della Saar, la cui produzione – unita a quella della Slesia – era divenuta estremamente vitale per la prosecuzione della guerra, costringendo così i tedeschi all’impiego prematuro di tutti i mezzi di difesa elettronica della serie “Fuerball” (ancora in fase sperimentale), ma grazie alla straordinaria perizia dei membri del 100°Bombergroup che pose in atto sofisticati sistemi antiradar “accecando totalmente” l’operazione “Fuerball“, lo Stato Maggiore Tecnico delle “SS” ordinò la distruzione totale degli aviogetti rimasti in dotazione.

1945 – Le armi atomiche tedesche

Il 29 ottobre 1945, a guerra conclusa, rispondendo ad una interrogazione del conservatore P.W.Donner, il quale aveva chiesto al governo inglese se si fosse messo in contatto con gli scienziati tedeschi che avevano svolto ricerche atomiche presso i laboratori segreti dell’isola danese di Bornholm (presidiata dai sovietici dal maggio 1944), il premier Attlee dichiarò evasivamente che il Governo Inglese era “…perfettamente al corrente di tutte le ricerche condotte dai nazisti nel campo dell’atomo”.

Da esso risultava che gli scienziati operativi con le “SS” erano circa 5’000 uomini mentre gli esperti americani, operanti in concorrenza, non erano oltre i 200.

Da ciò risultava la conferma definitiva che i tedeschi avevano progettato un aeroplano a propulsione atomica capace di raggiungere teoricamente delle velocità dell’ordine delle 10’000 miglia orarie (16’000 Km./h.) senza poterlo portare a termine perché negli ultimi tempi della guerra “…le loro capacità inventive risultavano troppo superiori alla effettiva possibilità di trasferire al campo industriale i risultati delle loro ricerche teoriche.